9 minute gelesen

02/03/2024

Entmystifizierung von Mixture of Experts (MoE): Die Zukunft für tiefe GenAI-Systeme

Verstehen Sie, was eine Expertenmischung ist, wie sie funktioniert und warum sie hinter den besten LLM-Architekturen steht.

Das Konzept der Expertenmischung verstehen

Die MoE-Struktur erschien lange bevor Deep Learning und KI zu populären Konzepten wurden. Das Konzept der "Mixture of Experts" (MoE) wurde 1991 von Robert A. Jacobs und Michael I. Jordan vom Department of Brain and Cognitive Sciences am MIT sowie von Steven J. Nowlan und Geoffrey E. Hinton (Alan-Turing-Preisträger, Leiter der KI-Abteilung bei Google, eine Position, die er im Mai 2023 aufgab) vom Department of Computer Science an der University of Toronto vorgeschlagen und ist eine Technik des maschinellen Lernens, die auf der Verwendung großer Datenmengen basiert und das Training mehrerer Modelle beinhaltet. Die Architektur verwendet ein bedingtes Berechnungsparadigma, bei dem nur Teile eines Ensembles, die so genannten "Experten", ausgewählt und in Abhängigkeit von den Daten oder der Aufgabe aktiviert werden. Jedes Modell bzw. jeder "Experte" ist auf einen anderen Teil des Eingaberaums spezialisiert, so dass es eine Vorhersage für eine bestimmte Eingabe treffen kann. Die Vorhersagen werden dann zu einer endgültigen Ausgabe kombiniert, die auf dem Vertrauensniveau der Experten basiert. MoE verhält sich dennoch wie ein einziges, großes Modell.

Warum sollten Sie eine Mischung aus Experten verwenden?

Der 'Mixture of Experts' (MoE) wurde erfolgreich in verschiedenen Anwendungsbereichen eingesetzt. In der Verarbeitung natürlicher Sprache wurde MoE beispielsweise für maschinelle Übersetzungen, Stimmungsanalyse und Frage-Antwort-Aufgaben eingesetzt. Durch die Kombination der Vorhersagen mehrerer Sprachmodelle kann MoE die Genauigkeit von Übersetzungen verbessern und das Stimmungsbild komplexer Texte verstehen.

In der Computer Vision wurde MoE für die Objekterkennung, Bildbeschreibung und Videobeschreibung eingesetzt. Durch die Kombination der Ausgaben mehrerer Modelle kann MoE eine genaue Objekterkennung in Bildern durchführen, beschreibende Bildunterschriften generieren und Videoinhalte analysieren.

MoE hat auch Anwendungen in Empfehlungssystemen gefunden, in denen es zur Personalisierung von Empfehlungen basierend auf Nutzerpräferenzen und -verhalten verwendet wird. Durch die Kombination der Vorhersagen mehrerer Empfehlungsmodelle kann MoE genauere und vielfältigere Empfehlungen bereitstellen, was zu einer verbesserten Nutzerzufriedenheit führt.

Die Vorteile der Verwendung von MoE in diesen Anwendungen umfassen verbesserte Genauigkeit, Robustheit gegenüber komplexen Daten und Anpassungsfähigkeit an verschiedene Nutzerpräferenzen. MoE kann komplexe Muster und Beziehungen in den Daten erfassen, was zu genaueren Vorhersagen führt. Es ist auch robust gegenüber vielfältigen und verrauschten Daten, was es für den Einsatz in der Praxis geeignet macht. Darüber hinaus kann MoE an Nutzerpräferenzen angepasst werden, indem es Gewichte den Experten zuweist, abhängig vom Nutzerfeedback, was personalisierte Empfehlungen ermöglicht.

Zweck eines MoE (Mixture of Experts) im maschinellen Lernen

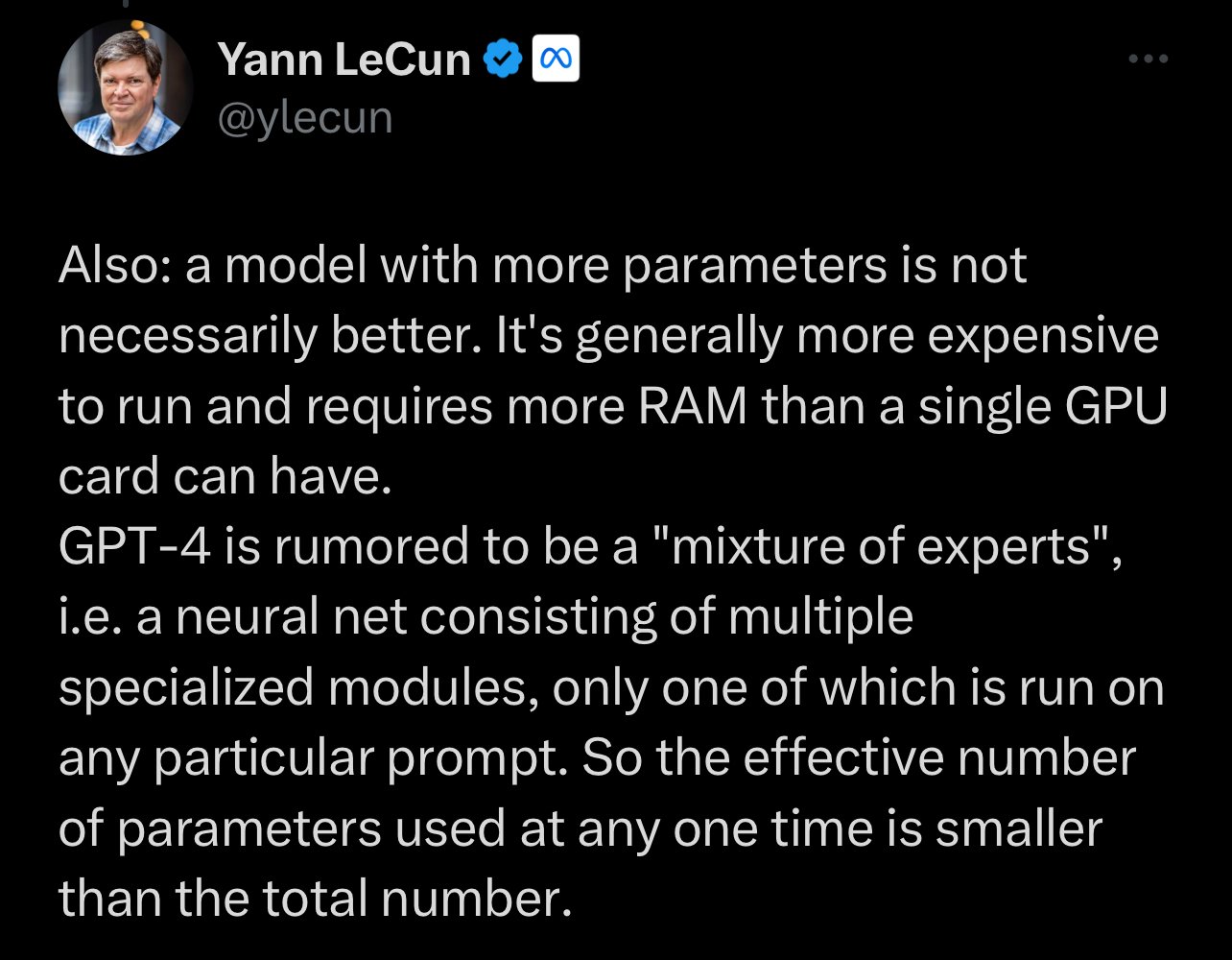

Wie bereits erwähnt, verwenden wir den Begriff MoE im maschinellen Lernen, um eine Ensemble-Lernmethode zu definieren, die die Vorhersagen mehrerer 'Experten'-Modelle kombiniert, um genauere und robuster Vorhersagen zu treffen. Beispiele sind ChatGPT (das Gerüchten zufolge ein acht Experten-System mit 277 Milliarden Parametern ist) oder Mixtral 8x7B (das in seinem Namen erklärt, ein acht Experten-System zu sein, aber auf 7 Milliarden Parametern trainiert wurde). Lassen Sie sich nicht von der Annahme täuschen, dass mehr Parameter ein 'besseres' System bedeuten. Kleine, spezialisierte Systeme, die ChatGPT in mehreren Aufgaben geschlagen haben, sind erschienen.

Die Idee hinter MoE ist, dass verschiedene Modelle möglicherweise besser darin sind, genaue Vorhersagen für spezifische Teilmengen der Daten zu treffen. Dadurch kann das Ensemble die Einschränkungen eines einzelnen Modells überwinden und insgesamt eine bessere Leistung erzielen.

"Wir werden sehen, dass kleine Modelle mit großen Kontextfenstern, verbessertem Fokus und Zugang zu privaten Datenbanken die Zukunft der KI sein werden. Dies ermöglicht es KI-Systemen, Tools wie Vektordatenbanken und Wissensgraphen zu nutzen, um ständig aktualisierte Daten zu verwenden, anstatt sich ausschließlich auf statische oder veraltete Trainingsdaten zu verlassen." - Manuel Herranz, CEO

Wie funktioniert ein Mixture of Experts

Das MoE-Verfahren funktioniert, indem die Eingabedaten in mehrere Teilmengen, oder "Cluster", basierend auf einer Ähnlichkeitsmetrik aufgeteilt werden. Anschließend wird jeder Cluster einem bestimmten Expertenmodell zugewiesen, das darauf trainiert wurde, Vorhersagen für diesen Cluster zu spezialisieren. Jeder Experte wurde unabhängig voneinander auf einer Teilmenge des Trainingsdatensatzes trainiert, wobei ein spezifisches Algorithmus oder Architektur verwendet wurde, das seinen besonderen Stärken entspricht. Beispielsweise könnte ein Experte ein tiefes neuronales Netzwerk mit vielen Schichten verwenden, um komplexe Beziehungen in den Daten zu erfassen, während ein anderer ein einfaches lineares Regressionsmodell verwendet, um einfache Fälle zu behandeln.

Sobald alle Experten trainiert wurden, werden sie in ein einziges System durch ein Gateing-Mechanismus integriert, der bestimmt, welche Gewichtung oder Bedeutung jedem Expertenausgang zugewiesen wird, abhängig von den Eingabefunktionen und dem Vertrauensniveau jedes Experten.

Bei der Vorhersage bestimmt das MoE zunächst, in welchen Bereich die Eingabe fällt, und verwendet dann das entsprechende Expertenmodell, um die Vorhersage zu treffen. Dadurch kann das MoE die Stärken verschiedener Modelle für verschiedene Teile des Eingaberaums nutzen, was zu genaueren und robusteren Vorhersagen führt. Die endgültige Vorhersage des MoE-Modells ist eine gewichtete Kombination der Projektionen aller Expertenmodelle. Der Gateing-Mechanismus bestimmt in der Regel die Gewichte für die Kombination.

Schlüsselkomponenten einer Expertenmischung (Mixture of Experts)

Eine Expertenmischung besteht aus mehreren Schlüsselkomponenten, die zusammenwirken, um genaue Vorhersagen zu treffen. Zu diesen Komponenten gehören:

1.Experten: Dies sind die einzelnen Modelle, die auf bestimmte Teilaufgaben oder Teilmengen des Eingaberaums spezialisiert sind. Jeder Experte ist für die Erstellung von Vorhersagen auf der Grundlage seines Fachwissens verantwortlich.

2. Gating-Netzwerk: Das Gating-Netzwerk bestimmt die Beiträge der einzelnen Experten auf der Grundlage der Eingabedaten. Es ordnet den Vorhersagen der einzelnen Experten Gewichte zu und stellt so sicher, dass die Ergebnisse der relevantesten Experten eine höhere Bedeutung erhalten.

3. Kombinationsverfahren: Bei der Kombinationsmethode werden die Vorhersagen aller Experten kombiniert, um die endgültige Vorhersage zu erstellen. Dabei kann es sich um eine einfache Durchschnittsbildung der Ergebnisse handeln oder um anspruchsvollere Techniken wie die gewichtete Durchschnittsbildung oder die Stapelung.

4. Trainingsalgorithmus: Der Trainingsalgorithmus ist für die Optimierung der Parameter der Experten und des Gating-Netzwerks verantwortlich. Er zielt darauf ab, den Vorhersagefehler zu minimieren und die Gesamtleistung des MoE-Modells zu maximieren.

Diese Schlüsselkomponenten arbeiten zusammen, um die Stärken der verschiedenen Modelle zu nutzen und genaue Vorhersagen zu treffen. Durch die Kombination der Ergebnisse mehrerer Experten kann MoE komplexe Beziehungen erfassen und die Gesamtgenauigkeit der Vorhersagen verbessern.

Dasa Gate

Das Gateing-Netzwerk oder das Gateing-Mechanismus nimmt in der Regel die Form eines separaten neuronalen Netzwerks an, das lernt,

Dies ermöglicht es dem Gesamtsystem, sich dynamisch an neue Eingaben anzupassen und die relativen Beiträge jedes Experten entsprechend anzupassen. Während des Trainings werden sowohl die Experten als auch der Gateing-Mechanismus gleichzeitig aktualisiert, um den Gesamtfehler über den gesamten Datensatz zu minimieren.

Das Gateing-Netzwerk nimmt die Eingabe entgegen und gibt einen Vektor von Wahrscheinlichkeiten aus, die dann verwendet werden, um eine gewichtete Summe der Vorhersagen der Expertenmodelle zu berechnen. Wenn man darüber nachdenkt, fängt dieses Mixture of Experts besser an, widerzuspiegeln, wie die Gehirne von Säugetieren arbeiten, mit getrennten Bereichen zur Verarbeitung von Gerüchen, Vision, Klang usw. Unser eigenes Gehirn aktiviert bestimmte Bereiche für bestimmte Aufgaben: Unsere Gehirne sind nicht "immer an" mit voller Kapazität, sondern sie arbeiten gleichzeitig an vielen Aufgaben. Neurologen haben den "10%-Mythosrologists widerlegt” eine populäre, haltlose Überzeugung, die früher behauptete, dass Menschen nur einen kleinen Bruchteil ihres Gehirns nutzen und magische Superkräfte nur erlangen könnten, wenn sie den Rest des Gehirns aktivieren könnten. Statt als ein einziger Klumpen zu agieren, hat das Gehirn getrennte Regionen für verschiedene Arten der Informationsverarbeitung. Jahrzehnte der Forschung haben dazu gedient, Funktionen den Bereichen des Gehirns zuzuordnen, und keine funktionslosen Bereiche wurden gefunden.

Die Wahrheit ist, dass einige Bereiche mehr "aktiviert" sind, wenn wir lesen, andere, wenn wir Essen zubereiten und kochen, und wieder andere, wenn wir Musik hören oder in ein tiefes Gespräch vertieft sind - aber das gesamte Gehirn ist auch in Schlafphasen aktiv und tauscht ständig Informationen aus: regulieren, überwachen, wahrnehmen, interpretieren, argumentieren, planen und handeln. Selbst Menschen mit degenerativen Nervenerkrankungen wie Alzheimer und Parkinson nutzen immer noch mehr als 10 % ihres Gehirns.

Gabrielle-Ann Torre, Redakteurin bei Knowing Neurons, entlarvt den Zehn-Prozent-Mythos, indem sie schreibt, dass es auch nicht wünschenswert wäre, das gesamte Gehirn zu nutzen, was genau der Funktionsweise einer MoE entspricht (während für eine Aufgabe mehrere Bereiche aktiv sein können, werden für Schlussfolgerungen nur zwei Agenten verwendet). Würde das gesamte Gehirn ungehindert für alle Aufgaben genutzt, würde dies mit ziemlicher Sicherheit einen epileptischen Anfall auslösen. Torre schreibt, dass eine Person selbst im Ruhezustand wahrscheinlich so viel von ihrem Gehirn wie möglich über das Standardmodus-Netzwerk nutzt, ein weit verbreitetes Gehirnnetzwerk, das auch dann aktiv und synchronisiert ist, wenn keine kognitive Aufgabe vorliegt. Torre sagt, dass "große Teile des Gehirns niemals wirklich inaktiv sind, wie es der Mythos von den 10 % suggerieren könnte".

Das Gating-Netzwerk fungiert fast wie ein Moderator, der weiß, welchem Experten und welchem Bereich zu welcher Zeit mehr Vertrauen geschenkt werden sollte: Es ist nicht dasselbe, sich auf das Laufen zu konzentrieren, wie auf das Schreiben eines Essays. Es ist nicht dasselbe, ein System zu bitten, Katalanisch zu übersetzen, wie es zu bitten, Python-Code zu schreiben oder das Konzept der Council Tax im Vereinigten Königreich zu erklären.

Vorteile von MoE

Ein wesentlicher Vorteil von MoE gegenüber anderen Ensemble-Methoden wie Bagging oder Boosting liegt in der größeren Flexibilität und Anpassungsfähigkeit der einzelnen Experten. Indem jedem Experten erlaubt wird, sich auf einen spezifischen Aspekt des Problemraums zu spezialisieren, kann MoE eine höhere Genauigkeit und bessere Generalisierung erreichen, als es mit einem einzigen, universellen Modell möglich wäre, egal ob es sich um ein 7B-, 13B-, 32B- oder 70B-Modell handelt. Diese zusätzliche Komplexität bringt allerdings auch Nachteile mit sich, wie gesteigerte Rechenanforderungen und potenzielle Optimierungsschwierigkeiten des Gating-Mechanismus.

MoE-Modelle haben sich in einer Vielzahl von Anwendungen bewährt, darunter in der Verarbeitung natürlicher Sprache, der Computer Vision und der Spracherkennung. Sie sind besonders nützlich in Situationen, in denen die Daten komplex und in unterschiedliche Segmente unterteilbar sind, und wo verschiedene Modelle für unterschiedliche Segmente besser geeignet sind.

Ein Hauptvorteil von MoE-Modellen ist der effizientere Einsatz von Rechenressourcen. Indem jedes Expertenmodell auf einen spezifischen Cluster spezialisiert wird, kann das Gesamtsystem effizienter gestaltet werden, da nicht ein einzelnes, umfassendes Modell mit dem gesamten Datensatz trainiert werden muss. Zudem können MoE-Modelle robuster gegenüber Veränderungen in der Datenverteilung sein, da das Gating-Netzwerk auf Änderungen reagieren und mehr Ressourcen den am besten geeigneten Expertenmodellen zuordnen kann.

Allerdings sind MoE-Modelle in der Trainings- und Implementierungsphase deutlich komplexer als traditionelle maschinelle Lernmodelle, da mehrere Modelle und ein Gating-Netzwerk trainiert werden müssen. Zudem besteht eine höhere Gefahr der Überanpassung, wenn die Anzahl der Cluster oder Expertenmodelle nicht sorgfältig ausgewählt wird.

Ein weiterer wesentlicher Vorteil von MoE-Modellen ist der effizientere Einsatz von Modellressourcen. Durch die Aufteilung des Eingabebereichs in mehrere Regionen und die Zuweisung eines spezifischen Expertenmodells zu jeder Region kann das MoE für jede Region kleinere, spezialisierte Modelle anstelle eines einzigen, großen, universellen Modells verwenden. Dies führt zu signifikanten Verbesserungen sowohl in der Recheneffizienz als auch in der Vorhersagegen.

Training und Implementierung eines Mixtures of Experts

Das Training eines Mixtures of Experts umfasst zwei Hauptschritte: das Training der Experten und das Training des Gating-Netzwerks.

Um die Experten zu trainieren, werden die Daten in Teilmengen unterteilt, die den Unteraufgaben oder Teilmengen des Eingaberaums entsprechen. Jeder Experte wird auf seiner entsprechenden Teilmenge trainiert, wobei seine Parameter so optimiert werden, dass er genaue Vorhersagen für die spezifische Unteraufgabe treffen kann.

Sobald die Experten trainiert sind, wird das Gating-Netzwerk mit den Eingabedaten und den Vorhersagen der Experten trainiert. Das Gating-Netzwerk lernt, Gewichte den Vorhersagen jedes Experten zuzuweisen, abhängig von den Eingabedaten, um sicherzustellen, dass der Ausgang des relevantesten Experten mehr Bedeutung beigemessen wird. Das Gating-Netzwerk wird in der Regel mit Techniken wie Backpropagation oder Verstärkungslernen trainiert.

Die Implementierung eines Mixtures of Experts umfasst das Entwerfen und Implementieren der Experten, des Gating-Netzwerks und der Kombinationsmethode. Die Experten können beliebige maschinelle Lernmodelle sein, wie neuronale Netze, Entscheidungsbäume oder Support Vector Machines. Das Gating-Netzwerk kann mit neuronalen Netzen oder anderen Techniken implementiert werden, die Gewichte den Vorhersagen der Experten zuweisen können. Die Kombinationsmethode kann so einfach sein wie das Durchschnitt der Ausgänge oder komplexere Techniken, je nach der spezifischen Anwendung.

Es ist wichtig, sorgfältig die Parameter und Architektur der Experten und des Gating-Netzwerks zu kalibrieren, um die bestmögliche Leistung zu erzielen. Darüber hinaus kann der Schulungsprozess einen großen Bestand an gekennzeichneten Daten und Rechenressourcen erfordern, abhängig von der Komplexität des Problems und den verwendeten Modellen.

Traditionalle gegenüber Sparse MoE

Der Unterschied zwischen traditionellen Mixture of Experts (MoE)-Modellen und Sparse MoE-Modellen liegt hauptsächlich in ihrer Architektur und wie sie Rechenressourcen zuweisen. Im Folgenden finden Sie die wichtigsten Unterschiede:

Traditionelle MoE-Modelle

1. Dichte Expertennutzung: In traditionellen MoE-Modellen sind in der Regel eine große Anzahl von Experten für jede Eingabe aktiv. Dies bedeutet, dass für eine bestimmte Datenmenge mehrere Experten ihre Ausgaben bereitstellen, die dann kombiniert werden, um das endgültige Ergebnis zu erzeugen.

2. Rechenaufwand: Da viele Experten an der Verarbeitung jeder Eingabe beteiligt sind, können traditionelle MoE-Modelle rechenintensiv sein. Dies kann zu Ineffizienzen führen, insbesondere wenn das Modell für große Datensätze oder komplexe Aufgaben skaliert wird.

3. Einheitliche Fachkenntnisse: Oft sind die Experten in traditionellen MoE-Modellen nicht hochspezialisiert. Sie können sich in ihren Fähigkeiten oder Wissensgebieten überschneiden, was zu redundanter Verarbeitung führt.

Sparse MoE-Modelle:

1. Selektive Expertenaktivierung: Sparse MoE-Modelle sind so konzipiert, dass nur eine kleine Teilmenge von Experten für jede Eingabe aktiviert wird. Das Gating-Netzwerk des Modells entscheidet intelligent, welche Experten für die spezifische Aufgabe am relevantesten sind, und reduziert so die Anzahl der aktiven Experten zu einem bestimmten Zeitpunkt.

2. Effizienz und Skalierbarkeit: Die Sparsamkeit bei der Expertenaktivierung macht diese Modelle effizienter und skalierbarer. Sie sind besser geeignet, um groß angelegte Aufgaben zu bewältigen, da sie die Rechenbelastung reduzieren, indem sie nur die erforderlichen Experten nutzen.

3. Spezialisierte Fachkenntnisse: In Sparse MoE-Modellen sind Experten oft spezialisierter. Jeder Experte ist auf eine bestimmte Art von Aufgabe oder Daten feinabgestimmt, so dass das Modell das relevanteste Wissen und die relevantesten Fähigkeiten für jede Eingabe nutzt.

4. Lastenausgleich und Ressourcenverwaltung: Sparse MoE-Modelle umfassen in der Regel Mechanismen für den Lastenausgleich zwischen den verschiedenen Experten und die effektivere Verwaltung von Rechenressourcen. Dies ist bei groß angelegten Anwendungen von entscheidender Bedeutung, bei denen die Optimierung der Ressourcen der Schlüssel ist und unsere Erfahrung mit dem Hosting bei Pangeanic uns sagt, dass es unerlässlich ist, einen guten, zuverlässigen Load Balancer zu haben, wenn Hunderte oder Tausende von Nutzern zu Spitzenzeiten auf Ihre Ressourcen zugreifen müssen. (Wir sind im Rennen um die Millionen von Nutzern noch nicht dabei).

Zusammenfassend lässt sich sagen, dass sowohl traditionelle als auch Sparse MoE-Modelle eine Sammlung von Experten zur Datenverarbeitung verwenden, aber Sparse MoE-Modelle (die neueste Generation) effizienter sind, wie sie diese Experten nutzen. Durch die selektive Aktivierung einer begrenzten Anzahl hochspezialisierter Experten für jede Aufgabe erreichen Sparse MoE-Modelle eine höhere Rechenleistung und Skalierbarkeit, was sie für komplexe, groß angelegte Anwendungen besser geeignet macht.

Herausforderungen und Zukunft von Mixture of Experts

Eine Herausforderung besteht in der Auswahl und Gestaltung der Experten. Es ist wichtig, Experten auszuwählen, die sich ergänzen und unterschiedliche Aspekte des Problems abdecken. Die Gestaltung effektiver Experten erfordert Fachwissen und Expertise sowie sorgfältiges Feature-Engineering.

Eine weitere Herausforderung ist die Schulung und Optimierung des Gating-Netzwerks (Gating-Mechanismus). Das Gating-Netzwerk muss lernen, den geeigneten Gewichten den Vorhersagen jedes Experten zuzuweisen, abhängig von den Eingabedaten. Dies erfordert einen großen Bestand an beschrifteten Daten und Rechenressourcen sowie eine sorgfältige Abstimmung der Netzwerkarchitektur und des Trainingsalgorithmus.

Die Zukunft von Mixture of Experts sieht sehr vielversprechend aus und ist der Bereich, in dem Pangeanic seine Anstrengungen in der Anpassung investiert. Mit Fortschritten im Bereich Deep Learning und KI gibt es Möglichkeiten, die Leistung und Effizienz von MoE-Modellen zu verbessern. Zukünftige Forschungen könnten sich darauf konzentrieren, fortschrittlichere Expertenmodelle zu entwickeln, neue Kombinationsmethoden zu erforschen und Wege zu finden, die Rechenanforderungen für das Training von MoE-Modellen zu reduzieren.

Insgesamt hat die Mixture of Experts-Architektur das Potenzial, das Feld der tiefen GenAI-Systeme zu revolutionieren, indem sie die Stärken mehrerer Modelle nutzt und komplexe Beziehungen in den Daten einfängt. Es ist ein aufregendes Forschungsgebiet mit vielversprechenden Anwendungen in verschiedenen Domänen.