10 lettura minuti

19/03/2024

Demistificare la Miscela di Esperti (MoE): Il futuro dei sistemi GenAI profondi

Capire cosa sia un Miscela di Esperti, come funziona e perché si trova alla base delle migliori architetture di apprendimento profondo.

Capire il concetto di Miscela di Esperti

La struttura MoE è apparsa molto tempo prima che il deep learning e l'IA diventassero concetti popolari. Inizialmente proposta nel 1991 da Robert A. Jacobs e Michael I. Jordan del Dipartimento di Scienze del Cervello e Cognitive al MIT e da Steven J. Nowlan e Geoffrey E. Hinton (vincitore del premio Turing, ex Capo di AI a Google, posizione che ha lasciato nel maggio 2023) del Dipartimento di Informatica dell'Università di Toronto, il concetto di "Miscela di Esperti" (MoE) è una tecnica di machine learning basata sull'uso di enormi quantità di dati che comporta l'addestramento di più modelli. L'architettura adotta un paradigma di calcolo condizionale selezionando solo parti di un insieme noto come ‘esperti’ e attivandoli in base ai dati o al compito. Ogni modello o 'esperto' si specializza in una diversa parte dello spazio di input, permettendogli di fare una previsione per un dato input. Le previsioni vengono quindi combinate in un'uscita finale basata sui livelli di fiducia degli esperti. Tuttavia, la MoE si comporta come un singolo, grande modello.

Perché utilizzare una miscela di esperti?

Un sistema Miscela di Esperti (MoE) è stato applicato con successo in vari ambiti, tra cui il trattamento del linguaggio naturale e la visione artificiale. Nell'elaborazione del linguaggio naturale, la MoE è stata utilizzata per la traduzione automatica, l'analisi del sentiment e la risposta alle domande. Combinando le previsioni di più modelli linguistici, la MoE può migliorare l'accuratezza della traduzione e comprendere il sentiment di testi complessi.

Nel campo della visione artificiale, il MoE è stato utilizzato per il riconoscimento degli oggetti, la didascalia delle immagini e l'analisi dei video. Combinando i risultati di più modelli, MoE può identificare con precisione gli oggetti nelle immagini, generare didascalie descrittive e analizzare i contenuti video.

I sistemi di raccomandazione hanno anche trovato vantaggio nell'utilizzo di MoE, poiché può personalizzare le raccomandazioni in base alle preferenze e al comportamento degli utenti. Combinando le previsioni di più modelli di raccomandazione, MoE può fornire raccomandazioni più accurate e diversificate, migliorando la soddisfazione degli utenti.

L'utilizzo di MoE in queste applicazioni presenta diversi vantaggi, tra cui una maggiore accuratezza, robustezza ai dati complessi e adattabilità alle diverse preferenze degli utenti. Le MoE sono in grado di catturare schemi e relazioni complesse nei dati, con conseguenti previsioni più accurate. Sono anche resistenti a dati diversi e rumorosi, il che li rende adatti per applicazioni reali. Inoltre, MoE può adattarsi alle preferenze dell'utente assegnando pesi agli esperti in base al feedback dell'utente, fornendo raccomandazioni personalizzate.

A cosa serve una Miscela di Esperti (MoE) nell'apprendimento automatico?

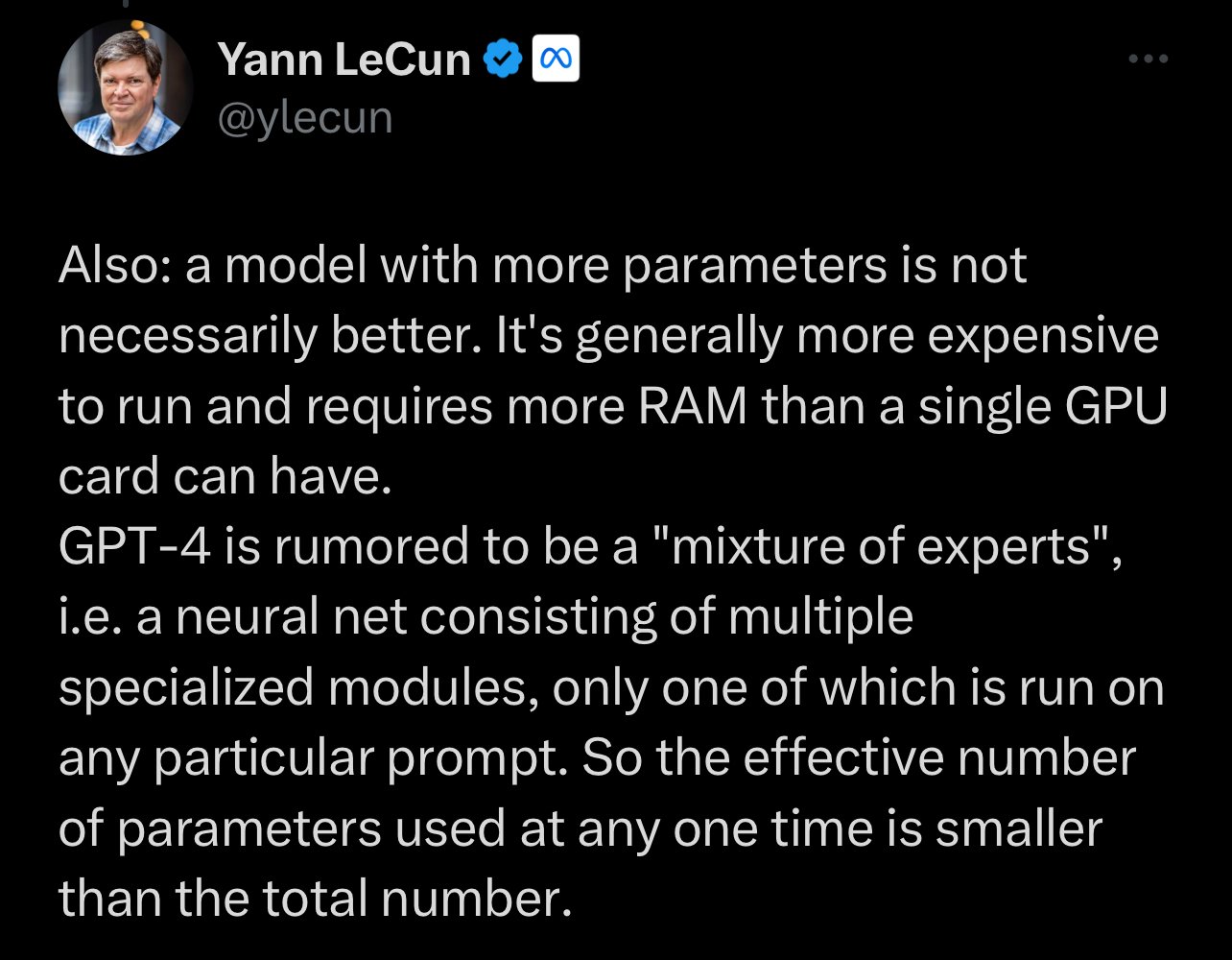

Nell'apprendimento automatico, il termine MoE si riferisce a un metodo di apprendimento di insiemi che combina le previsioni di diversi modelli "esperti" per effettuare previsioni più accurate e robuste. Ad esempio, ChatGPT (che si dice sia un sistema a otto esperti con 277B parametri) o Mixtral 8x7B (che dichiara nel suo nome di essere anch'esso un sistema a otto esperti, ma addestrato su 7B parametri). Tuttavia, non lasciatevi ingannare dall'idea che un maggior numero di parametri renda automaticamente un sistema "migliore". Sistemi più piccoli e specializzati che battono ChatGPT in diversi compiti sono già apparsi.

L'idea alla base del MoE è che diversi modelli possano essere migliori nel fare previsioni accurate per specifici sottoinsiemi dei dati, in modo che l'insieme possa superare le limitazioni di ogni singolo modello e fornire una migliore performance complessiva.

"Vedremo che i piccoli modelli con ampie finestre di contesto, un'attenzione migliorata e l'accesso a repository di dati privati saranno il futuro dell'IA. Questo consente ai sistemi di IA di utilizzare strumenti come database vettoriali e grafi di conoscenza per sfruttare dati aggiornati in tempo reale, anziché fare affidamento solo su training statici o obsoleti." - Manuel Herranz, CEO

Come funziona una Miscela di Esperti

Un sistema Miscela di Esperti (MoE) divide i dati di input in diversi sottoinsiemi, o "cluster", in base a una metrica di somiglianza. Successivamente, ogni cluster viene assegnato a un modello esperto specifico, che è addestrato per specializzarsi nelle previsioni per quel cluster. Ogni esperto viene addestrato in modo indipendente su un sottoinsieme dei dati di addestramento utilizzando un algoritmo o un'architettura specifica per le sue competenze. Ad esempio, un esperto può utilizzare una rete neurale profonda con molti strati per catturare relazioni complesse nei dati, mentre un altro può utilizzare un modello di regressione lineare più semplice per gestire i casi più semplici.

Dopo che tutti gli esperti sono stati addestrati, vengono combinati in un unico sistema attraverso un meccanismo di gate, che determina l'importanza assegnata ai risultati di ciascun esperto in base alle caratteristiche di input e al livello di fiducia di ciascun esperto.

Al momento di effettuare una previsione, il MoE determina innanzitutto a quale regione appartiene l'input e quindi utilizza il modello esperto corrispondente per effettuare la previsione. Ciò consente al MoE di sfruttare i punti di forza di diversi modelli per le diverse parti dello spazio degli input, il che si traduce in previsioni più accurate e robuste. La previsione finale del modello MoE è una combinazione ponderata delle proiezioni di tutti i modelli esperti, con il meccanismo di gate che tipicamente determina i pesi per la combinazione.

Componenti chiave del Mixture of Experts

Un Mixture of Experts è composto da diversi componenti chiave che lavorano insieme per effettuare previsioni accurate. Questi componenti includono:

-

Esperti: Si tratta dei modelli individuali specializzati in specifici sotto-task o subset dello spazio di input. Ogni esperto è responsabile di formulare previsioni basate sulla sua conoscenza specializzata.

-

Rete di gate: La rete di gate determina i contributi di ciascun esperto basandosi sui dati di input. Assegna pesi alle previsioni di ciascun esperto, garantendo che l'output dell'esperto più rilevante riceva maggiore importanza.

-

Metodo di combinazione: Il metodo di combinazione unisce le previsioni di tutti gli esperti per formare la previsione finale. Questo può essere semplice come la media delle uscite o può utilizzare tecniche più sofisticate, come la media ponderata o lo stacking.

-

Algoritmo di addestramento: L'algoritmo di addestramento è responsabile dell'ottimizzazione dei parametri degli esperti e della rete di gate. Ha lo scopo di minimizzare l'errore di previsione e massimizzare le prestazioni complessive del modello MoE.

Questi componenti chiave lavorano insieme per sfruttare i punti di forza di diversi modelli ed effettuare previsioni accurate. Combinando le uscite di diversi esperti, il MoE può catturare relazioni complesse e migliorare l'accuratezza complessiva delle previsioni.

La rete di gate

La rete di gate o meccanismo di gate di solito prende la forma di una rete neurale separata che impara

- a prevedere la probabilità di un input che appartiene a ciascun cluster, e

- a prevedere quale esperto si esibirà meglio data una particolare input.

Ciò consente al sistema nel suo insieme di adattarsi dinamicamente a nuovi input e di regolare i contributi relativi di ciascun esperto di conseguenza. Durante l'addestramento, sia gli esperti che la rete di gate vengono aggiornati simultaneamente per minimizzare l'errore complessivo su l'intero dataset.

La rete di gating prende l'input ed emette un vettore di probabilità, che viene poi utilizzato per calcolare una somma ponderata delle previsioni dei modelli esperti. Se ci pensate, questa miscela di esperti riflette meglio il funzionamento del cervello dei mammiferi, con aree distinte per l'elaborazione di odori, visioni, suoni, ecc. Il nostro stesso cervello attiva alcune aree per determinati compiti: il nostro cervello non è "sempre acceso" a pieno regime, ma lavora sempre su molti compiti. I neurologi hanno sfatato il "mito del 10%", una credenza popolare priva di fondamento che affermava che gli esseri umani utilizzavano solo una piccola parte del loro cervello e potevano ottenere superpoteri magici solo se riuscivano a risvegliare il resto del cervello. Invece di agire come un'unica massa, il cervello ha regioni distinte per diversi tipi di elaborazione delle informazioni. Decenni di ricerca sono stati dedicati alla mappatura delle funzioni nelle aree del cervello e non sono state trovate aree prive di funzioni.

La verità è che alcune aree sono più "attivate" durante la lettura, altre durante la preparazione del cibo e la cottura, e altre ancora quando ascoltiamo musica o siamo impegnati in una conversazione profonda, ma l'intero cervello è attivo anche durante i periodi di sonno e scambia continuamente informazioni: regola, monitora, avverte, interpreta, ragiona, pianifica e agisce. Anche le persone con disturbi neurali degenerativi come l'Alzheimer e il Parkinson utilizzano ancora più del 10% del loro cervello.

Nello sfatare il mito del dieci per cento, la redattrice di Knowing Neurons Gabrielle-Ann Torre scrive che non sarebbe auspicabile nemmeno utilizzare tutto il proprio cervello, che è esattamente come funziona una MoE (mentre diverse aree possono essere attive per un compito, solo due agenti sono utilizzati per l'inferenza). Se tutto il cervello venisse usato liberamente per tutti i compiti, quasi certamente si scatenerebbe un attacco epilettico. Torre scrive che, anche a riposo, una persona probabilmente utilizza la maggior parte del suo cervello per quanto ragionevolmente possibile attraverso la rete di modalità predefinita, una rete cerebrale diffusa che è attiva e sincronizzata anche in assenza di qualsiasi compito cognitivo. Torre afferma che "ampie porzioni del cervello non sono mai veramente inattive, come il mito del 10% potrebbe suggerire".

La rete di gate agisce quasi come un maestro di cerimonie, sapendo quale esperto e area trust più in ogni momento: non è la stessa cosa concentrarsi sulla corsa rispetto alla scrittura; non è la stessa cosa richiedere un sistema di tradurre il catalano rispetto a richiedergli di scrivere codice Python o avere una spiegazione del concetto di Consiglio fiscale nel Regno Unito.

Vantaggi di MoE

Un vantaggio fondamentale del MoE rispetto ad altri metodi di ensemble come il bagging o il boosting è che consente una maggiore flessibilità e personalizzazione dei singoli esperti. Consentendo a ciascun esperto di specializzarsi in un particolare aspetto dello spazio problematico, il MoE può raggiungere una maggiore accuratezza e una migliore generalizzazione rispetto a quanto sarebbe possibile con un singolo modello monolitico che va bene per "tutto", sia esso un 7B, un 13B, un 32B o un 70B. Questa maggiore complessità comporta anche alcuni svantaggi, come l'aumento dei requisiti computazionali e le potenziali difficoltà nell'ottimizzazione del meccanismo di gating.

I modelli MoE si sono dimostrati efficaci in diverse applicazioni, come l'elaborazione del linguaggio naturale, la computer vision e il riconoscimento vocale. Sono particolarmente utili in situazioni in cui i dati sono complessi e possono essere suddivisi in sottoinsiemi distinti e in cui modelli diversi possono essere più adatti a fare previsioni per sottoinsiemi diversi.

Uno dei vantaggi principali dei modelli MoE è che consentono un uso più efficiente delle risorse computazionali. Specializzando ogni modello esperto a un cluster specifico, il sistema complessivo può essere reso più efficiente, evitando di addestrare un singolo modello monolitico sull'intero set di dati. Inoltre, i modelli MoE possono essere più robusti ai cambiamenti nella distribuzione dei dati, in quanto la rete di gating può adattarsi ai cambiamenti dei dati e allocare più risorse ai modelli esperti che sono più adatti a gestire i nuovi dati.

Tuttavia, i modelli MoE sono molto più complessi da addestrare e implementare rispetto ai modelli tradizionali di apprendimento automatico, in quanto richiedono l'addestramento di più modelli e di una rete di gating. Inoltre, i modelli MoE possono essere più inclini all'overfitting se il numero di cluster o di modelli esperti non viene scelto con attenzione.

Uno dei vantaggi principali dei modelli MoE è che consentono un uso più efficiente delle risorse del modello. Dividendo lo spazio di input in più regioni e assegnando un modello esperto diverso a ciascuna regione, il MoE può utilizzare un modello più piccolo e specializzato per ciascuna regione, invece di utilizzare un unico modello generico di grandi dimensioni. Questo può portare a significativi miglioramenti sia nell'efficienza computazionale che nell'accuratezza predittiva.

Un altro vantaggio dei modelli MoE è che sono altamente flessibili e possono essere facilmente adattati a una vasta gamma di compiti e domini di input. Aggiungendo o rimuovendo modelli esperti e regolando la rete di gate, l'MoE può essere facilmente personalizzato per soddisfare le esigenze di un compito o di un'applicazione specifica.

Addestramento e implementazione di Mixture of Experts

L'addestramento di un Mixture of Experts coinvolge due fasi principali: l'addestramento degli esperti e l'addestramento della rete di gate.

Per addestrare gli esperti, i dati vengono suddivisi in subset basati sui sotto-task o sui sottoinsiemi dello spazio di input. Ciascun esperto viene addestrato sul suo subset corrispondente, ottimizzando i suoi parametri per effettuare previsioni accurate per quel particolare sotto-task.

Una volta addestrati gli esperti, la rete di gate viene addestrata utilizzando i dati di input e le previsioni degli esperti. La rete di gate impara ad assegnare pesi alle previsioni di ciascun esperto in base ai dati di input, garantendo che l'output dell'esperto più rilevante sia dato maggiore importanza. La rete di gate viene tipicamente addestrata utilizzando tecniche come la retropropagazione o il reinforcement learning.

L'implementazione di un Mixture of Experts coinvolge la progettazione e l'implementazione degli esperti, della rete di gate e del metodo di combinazione. Gli esperti possono essere qualsiasi modello di apprendimento automatico, come reti neurali, alberi decisionali o macchine a vettori di supporto. La rete di gate può essere implementata utilizzando reti neurali o altre tecniche che possono assegnare pesi alle previsioni degli esperti. Il metodo di combinazione può essere semplice come la media delle uscite o l'utilizzo di tecniche più sofisticate, a seconda dell'applicazione specifica.

È importante regolare attentamente i parametri e l'architettura degli esperti e della rete di gate per ottenere le migliori prestazioni. Inoltre, il processo di addestramento può richiedere una grande quantità di dati etichettati e risorse computazionali, a seconda della complessità del problema e dei modelli utilizzati.

MoE tradizionale versus MoE sparso

La differenza tra i modelli tradizionali Mixture of Experts (MoE) e i modelli MoE sparsi risiede principalmente nella loro architettura e nel modo in cui allocano le risorse computazionali. Vediamo le distinzioni chiave:

Modelli MoE tradizionali:

1. Utilizzo denso degli esperti: Nei modelli MoE tradizionali, un numero significativo di esperti è tipicamente attivo per ciascun input. Ciò significa che per qualsiasi dato, più esperti forniscono le loro uscite, che vengono poi combinate per produrre il risultato finale.

2. Sovraccarico computazionale: Poiché molti esperti sono coinvolti nel processo di elaborazione di ciascun input, i modelli MoE tradizionali possono essere computazionalmente costosi. Ciò può portare a inefficienze, specialmente quando si scala il modello per grandi set di dati o compiti complessi.

3. Competenza uniforme: Spesso, gli esperti nei modelli MoE tradizionali non sono altamente specializzati. Possono avere competenze o aree di conoscenza sovrapposte, portando a un'elaborazione ridondante.

Modelli MoE sparsi:

1. Attivazione selettiva degli esperti: I modelli MoE sparsi sono progettati per attivare solo un piccolo sottoinsieme di esperti per ciascun input. La rete di gate del modello decide intelligentemente quali esperti sono più rilevanti per il compito specifico, riducendo così il numero di esperti attivi in ogni momento.

2. Efficienza e scalabilità: La sparità nell'attivazione degli esperti rende questi modelli più efficienti e scalabili. Sono più adatti per gestire compiti su larga scala perché riducono il carico computazionale utilizzando solo gli esperti necessari.

3. Competenze specializzate: Nei modelli MoE sparsi, gli esperti sono spesso più specializzati. Ogni esperto è tarato per un tipo specifico di compito o dati, garantendo che il modello sfrutti la conoscenza e le competenze più rilevanti per ciascun input.

4. Bilanciamento del carico e gestione delle risorse: I modelli MoE sparsi includono tipicamente meccanismi per bilanciare il carico tra diversi esperti e gestire le risorse computazionali in modo più efficace. Questo è cruciale in applicazioni su larga scala, dove l'ottimizzazione delle risorse è fondamentale.

In breve, mentre sia i modelli MoE tradizionali che quelli sparsi utilizzano una collezione di esperti per elaborare i dati, i modelli MoE sparsi (la generazione più recente) sono più efficienti nel modo in cui utilizzano questi esperti. Attivando selettivamente un numero limitato di esperti altamente specializzati per ciascun compito, i modelli MoE sparsi raggiungono una maggiore efficienza computazionale e scalabilità, rendendoli più adatti per applicazioni complesse su larga scala.

Sfide e futuro di Mixture of Experts

Una sfida è la selezione e il design degli esperti. È importante scegliere esperti che si integrino tra loro e coprano diversi aspetti del problema. Progettare esperti efficaci richiede conoscenze del dominio e competenze, oltre a un'ingegneria delle caratteristiche attenta.

Un'altra sfida è l'addestramento e l'ottimizzazione della rete di gate (meccanismo di gate). La rete di gate deve imparare ad assegnare i pesi appropriati alle previsioni di ciascun esperto in base ai dati di input. Ciò richiede una grande quantità di dati etichettati e di risorse computazionali, nonché un'attenta messa a punto dell'architettura della rete e dell'algoritmo di addestramento.

Il futuro della Miscela di Esperti è molto promettente ed è su questo che Pangeanic sta concentrando i suoi sforzi di personalizzazione. Con i progressi del Deep Learning e dell'IA, ci sono opportunità per migliorare le prestazioni e l'efficienza dei modelli MoE. La ricerca futura potrebbe concentrarsi sullo sviluppo di modelli esperti più avanzati, sull'esplorazione di nuovi metodi di combinazione e sulla ricerca di modi per ridurre i requisiti computazionali dell'addestramento dei modelli MoE.

Tuttavia, nonostante le sfide, i modelli Mixture of Experts continuano a rappresentare un'area di ricerca promettente nell'ambito dell'apprendimento automatico e dell'intelligenza artificiale. L'approccio MoE offre un'architettura flessibile e scalabile che può essere adattata a una vasta gamma di compiti e domini applicativi. Con ulteriori sviluppi nell'ottimizzazione degli esperti, dei meccanismi di gate e delle tecniche di addestramento, i modelli MoE potrebbero diventare sempre più diffusi e potenti in futuro.