3 minutos de lectura

05/07/2024

¿Qué es RAG? La clave para los asistentes virtuales con conocimiento del mundo real

En el campo de la inteligencia artificial generativa (GenAI) privada hay un componente clave que está revolucionando la forma en que los asistentes virtuales acceden y utilizan el conocimiento del mundo real: RAG, o Modelo de Recuperación y Generación.

¿Pero qué es exactamente RAG?

RAG es una arquitectura innovadora que combina la potencia de los modelos de lenguaje de última generación con la capacidad de recuperar información de bases de conocimiento externas. Esta combinación sinérgica permite a los asistentes virtuales brindar respuestas más informadas, precisas y actualizadas, superando las limitaciones de los enfoques tradicionales basados únicamente en el conocimiento aprendido durante el entrenamiento. Recordemos que una de las grandes limitaciones de los primeros LLMs con capacidades conversacionales como ChatGPT 3.5 era que su conocimiento terminaba en una fecha concreta. No sabían que había pasado más allá de octubre o noviembre de 2021 o 2022. Con el tiempo, se han ido añadiendo funcionalidades de búsqueda en Internet que resumen la información de los 3, 4 o 5 mejores resultados. De todos modos, este enfoque puede dejar fuera mucha información y sigue estando abierto a alucinaciones pues los resultados de una búsqueda en internet pueden no tener la información más relevante para nosotros hasta la segunda o tercera página.

¿Para qué sirve un sistema RAG y asistente virtual como ECOChat?

Imagine una empresa, negocio u organización (no tienen porqué ser muy grandes). Todas ellas crean y tienen acceso a grandes cantidades de datos que se han ido recopilando a lo largo del tiempo. No necesariamente como consecuencia de sus operaciones: normas ISO, procedimientos internos, reglamentos, contratos, legislación aplicable que ha de mantenerse al día, incluso información de la competencia, informes y reportes sectoriales… El departamento de marketing tendrá un conjunto de documentos, el de finanzas otro, recursos humanos otro… La búsqueda de información se convierte pronto en un caos, con todas las ineficiencias que ello acarrea.

Gran parte de estos datos son texto e imágenes no estructuradas. Los enfoques convencionales para analizar datos no estructurados para generar nuevo contenido se basan en la coincidencia de palabras clave o sinónimos. Pero utilizando este enfoque, es imposible capturar todo el contexto semántico de un documento (o la información a través de documentos). De nuevo, nos encontramos frente a un problema de gestión de conocimiento, ineficiencias verticales y horizontales que afectan al negocio. En algunos casos, las consecuencias son incluso peores porque la organización o empresa podría estar monetizando sus contenidos y conocimientos, cobrando subscripciones… pero no hay forma de encontrar los datos relevantes para los clientes internos o externos.

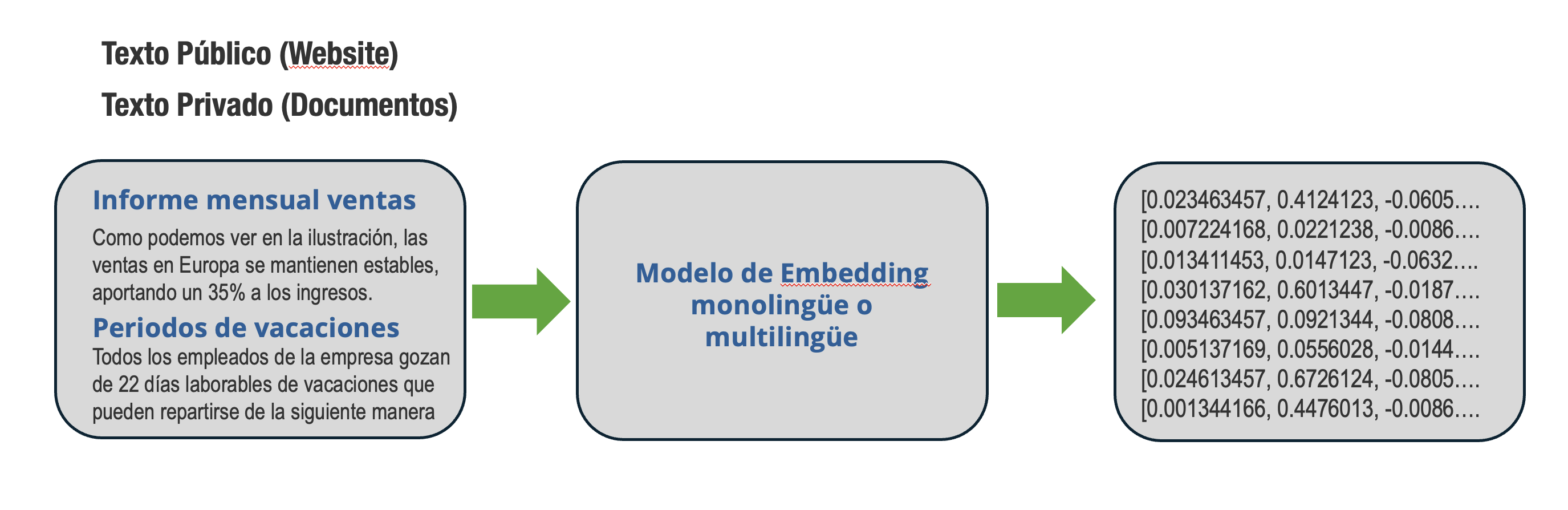

La conversión de texto en “word embeddings” (lo que Microsoft llama “incrustaciones”) utiliza capacidades de aprendizaje automático (ML) para capturar la esencia de los datos no estructurados. Estas incrustaciones se generan mediante modelos de lenguaje que mapean texto de lenguaje natural en sus representaciones numéricas y, en el proceso, codifican información contextual en el documento. La conversión de texto en incorporaciones es el primer paso para muchas aplicaciones de procesamiento de lenguaje natural (NLP) aumentadas por grandes modelos de lenguaje (LLMs) como Generación Aumentada por Retrieval (RAG), generación de texto, extracción de entidades y varios otros procesos comerciales posteriores.

Conversión de texto a incrustraciones (embeddings) utilizando un modelo de monolingüe o multilingüe

Conversión de texto a incrustraciones (embeddings) utilizando un modelo de monolingüe o multilingüe

¿Cómo funciona un sistema RAG?

El corazón del sistema RAG es un modelo de recuperación que puede buscar de manera eficiente en grandes bases de datos de conocimiento, como Wikipedia o bases de datos especializadas. Este modelo utiliza técnicas de recuperación de información para identificar los fragmentos de texto más relevantes para una consulta dada. A continuación, estos fragmentos se alimentan a un modelo de lenguaje generativo, que los procesa y genera una respuesta coherente y contextualizada.

Uno de los aspectos más poderosos de RAG es su capacidad para combinar el conocimiento aprendido durante el entrenamiento con la información recuperada de fuentes externas. Esto permite a los asistentes virtuales responder con mayor precisión a preguntas que requieren conocimiento actualizado o información específica de dominio.

Por ejemplo, si un usuario pregunta sobre un evento reciente, el modelo de recuperación de RAG puede buscar en fuentes en línea actualizadas para obtener los detalles más recientes, mientras que el modelo de lenguaje generativo puede integrar esta información en una respuesta fluida y natural.

Pero un sistema de asistente virtual basado en RAG no se limita solo a responder preguntas. También tiene aplicaciones en tareas como la generación de resúmenes, la escritura asistida y la conversión de texto a conocimiento estructurado. Al combinar el conocimiento aprendido y el conocimiento recuperado, RAG puede generar contenido más informado y relevante para una amplia gama de casos de uso.

Sin embargo, y como puede suceder con la interpretación humana, uno de los retos es garantizar la calidad y la precisión de las bases de conocimiento utilizadas, puesto que la generación de contenido reflejará cualquier sesgo o inexactitud en las fuentes d datos.

De todos modos, un asistente virtual basado en RAG como ECOChat representa un avance significativo en el campo de la Inteligencia Artificial Generativa, permitiendo a los asistentes virtuales brindar respuestas más informadas y precisas. A medida que la tecnología continúa evolucionando, es probable que veamos implementaciones más sofisticadas de RAG que aborden sus limitaciones actuales y amplíen aún más las capacidades de los asistentes virtuales.

Si nos quedamos con un concepto final, que sea este: un RAG es una arquitectura innovadora que permite a los asistentes virtuales con GenAI acceder y utilizar el conocimiento que nosotros queremos darles, de nuestro sector, empresa u organización, para que la información que proporcionan sea más precisa. Al combinar modelos de lenguaje potentes con la capacidad de recuperar información de fuentes externas, RAG está impulsando una nueva era de asistentes virtuales más informados, precisos y útiles, capaces de brindar experiencias de usuario más enriquecedoras y valiosas como nuestro ECOChat.

Ahorre miles de horas gestionando búsquedas internas y externas de información, consultas de clientes y personal. Sus datos siguen siendo privados y accesibles en toda su organización. Las alucinaciones, comunes en sistemas generales de IA, desaparecen. Utilice la GenAI adaptativa para traducción con LLMs y redes neuronales con posedición automática.